《自然》最新研究:AI或能和人类一样,理解和应用系统性思维

2023-11-08 来源:翻译狗

导读

近年来,AI行业迎来了新风口,Chat GPT、AlphaFold等高科技产品层出不穷。然而不管AI如何发展,许多人都坚信一点,那就是AI永远没法模拟人类的大脑。

AI和人脑的差别到底在哪里?

早在1988年,有学者指出AI缺乏系统泛化(systematic generalization)的能力,也就是说尽管AI学习新知识的能力很强,但它没法和人一样,将新知识与原有知识体系相结合。

不过,这一维持35年的“定律”可能要被打破了。

今天,《自然》(Nature)发表了一篇研究,研究中展示了一个具有类似人类系统泛化能力的计算模型,运用一种元学习组合性(MLC)方法优化计算模型的组合技能,证明计算模型能掌握与人类相似的系统泛化能力。

周 晨 | 撰文

AI能够模拟人类大脑吗?

很多人给出的答案恐怕都是:不能。

1988年,罗格斯大学认知科学中心的杰瑞·A·福多尔(Jerry A. Fodor)和泽农·W·皮利辛(Zenon W. Pylyshyn)发表论文论证AI与人类大脑的区别,那就是AI模型缺乏“系统泛化”的能力。

简单来说,虽然AI的学习能力很强大,但很难创建独属自己的知识脉络,将所学到的知识运用到具体的场景之中,而这被认为是AI区别人类的关键之处。

35年以来,这一论点一直备受青睐。

然而时至今日,这一观念可能要被打破了。

本周,纽约大学数据科学中心布伦登·M·莱克(Brenden Lake)团队和特伦托大学心智/脑科学中心马尔科·巴罗尼(Marco Baroni)联合在《自然》(Nature)发表一项研究,证明AI计算模型可以掌握与人类相似的系统泛化能力。

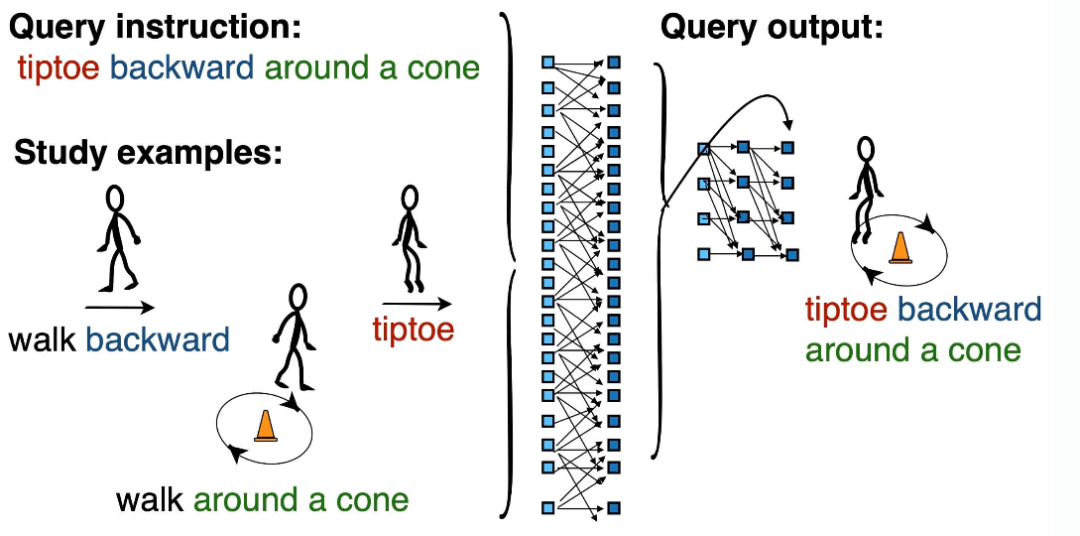

研究团队提出了一种称为元学习组合性(MLC)的方法,通过这种方法,AI计算模型能够优化其组合技能,只需通过高级引导或人类示例而无需添加符号来指导模型的学习。

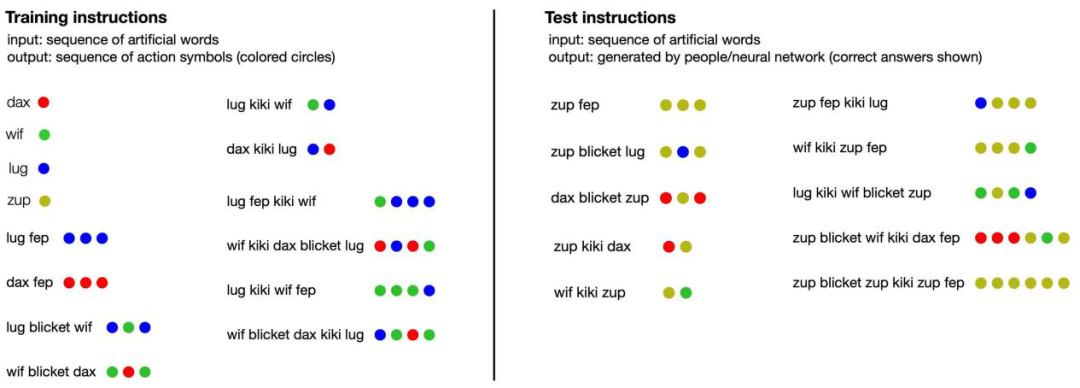

为了验证元学习组合性方法的有效性,研究团队进行了一系列实验,先对人类进行不同的组合任务的训练和测试后,再将数据与计算模型进行比较。

研究团队招募了25名志愿者,他们被要求处理指令并生成抽象结果,然后再根据测试数据总结出三种重要的归纳偏见(一对一翻译、图像串联和每个指令都分配唯一响应)。

之后,研究人员将优化过的计算模型与人类进行对比,发现模型有很强的表现能力,能够以接近人类性能的平均速率(82.4%)系统性输出,以接近人类水平的速率(77.8%)处理长输出序列。

另外,计算模型还能捕捉更微妙的响应模式,推断未知任务的新规则,在65.0%的样本中完全模拟人类参与者一样的响应,并在大多数情况下实现了与人类相似的归纳偏见:在所有计算模型样本中,66.0%遵循一对一翻译(人类中为62.1%),85.0%遵循图像串联(人类中为79.3%),99.0%选择了对每个唯一指令的唯一响应(人类中为93.1%)。

最令人印象深刻的是,这种计算模型能够将指令翻译成动作序列,例如将“走两次”翻译成“走走”,错误率低于0.22%。在将句子翻译成逻辑形式的实验中,错误率仅为0.87%。

与传统的符号模型和非系统性的计算模型相比,经过MLC方法优化的计算模型实现了与人类相似的系统性和灵活性。另外,MLC还在多个系统性泛化测试中提高了机器学习系统的组合技能。

虽然MLC方法无法让该计算模型对训练之外的任务进行泛化,但他们的研究结果将有助于今后开发出行为更像人类大脑的人工智能。

参考资料:

1.Human-like systematic generalization through a meta-learning neural network. Nature.

2.Connectionism and cognitive architecture: A critical analysis. APA PsycINFO.